引言

在数据驱动的世界里,高效的数据收集能力变得尤为关键。从商业决策到科学研究,从社交媒体分析到新闻报道,爬虫技术在搜集大量在线数据方面扮演了关键角色。本文旨在为那些希望从零开始学习爬虫技术的读者提供一份全面的指南,包括基本概念的理解、不同工具的选择、实践案例的分析以及道德与法律方面的考量。

什么是爬虫?

简单来说,爬虫是一种自动化的程序,它通过模拟用户行为的方式抓取互联网上公开可用的数据。爬虫广泛应用于数据挖掘、搜索引擎、内容聚合等诸多领域。理解爬虫的工作原理是学习的第一步。

爬虫工具与框架

目前市面上有多种爬虫工具与框架供选择,包括但不限于:

- **Scrapy**:一个高级的Python框架,特别适合爬取大型网站。

- **BeautifulSoup**:以解析HTML和XML文档而闻名,尤其是在Python社区中。

- **Selenium**:主要用于处理动态加载的网页内容,适合抓取需要登录验证或JavaScript渲染的内容。

选择最适合项目的工具,取决于目标网站的复杂性、需求以及团队的技术栈。

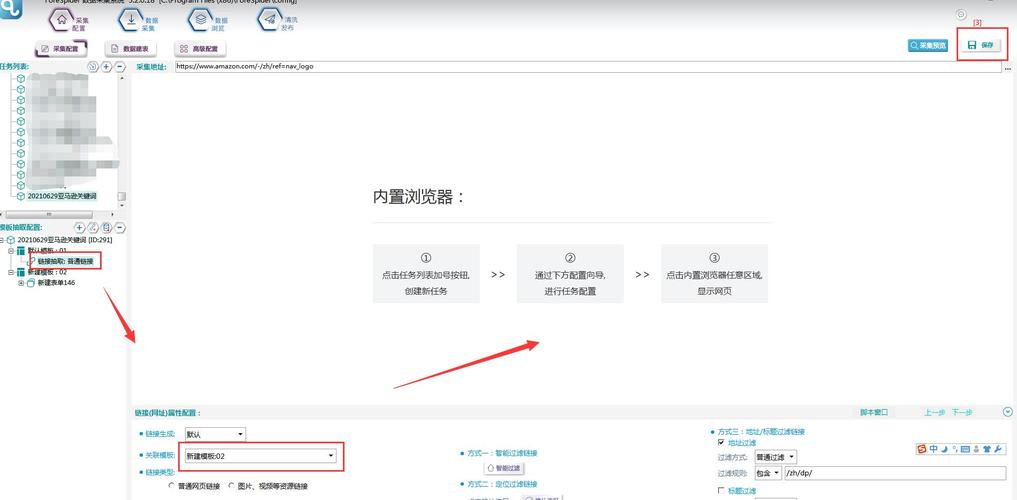

实战演练:构建你的第一个爬虫

构建一个简单的爬虫不仅可以帮助巩固理论知识,还能增强实际操作的能力。以Scrapy为例,构建一个抓取新闻网站的文章标题和链接的简单爬虫:

1. 安装Scrapy。

2. 创建一个新的Scrapy项目。

3. 定义爬虫参数(例如起始URL等)。

4. 编写解析函数,提取所需数据。

5. 运行爬虫并检查结果。

这里以具体代码为例,让您更直观地了解操作步骤。首先,安装Scrapy,并创建项目:

```bash

pip install scrapy

scrapy startproject mynews

```

定义爬虫(`mynews/spiders/first_spider.py`):

```python

import scrapy

class FirstSpider(scrapy.Spider):

name = 'first'

allowed_domains = ['example.com']

start_urls = ['http://example.com']

def parse(self, response):

for article in response.css('div.article'):

yield {

'title': article.css('h1.title::text').get(),

'link': article.css('a::attr(href)').get()

}

```

然后,运行爬虫:

```bash

scrapy crawl first

```

道德与法律考量

在开发和使用爬虫时,务必遵守相关法律法规,尊重网站的Robots协议以及个人隐私权。此外,频繁的爬取请求可能会对目标网站的服务器造成负担,因此合理控制爬取频率和间隔也是至关重要的。

结语

掌握爬虫技能不仅能提升个人技术能力,还能为未来的职业发展打开新大门。从基础理论到实战应用,每一步都充满挑战与乐趣。希望本文能为您的学习之旅提供有价值的指导和支持。